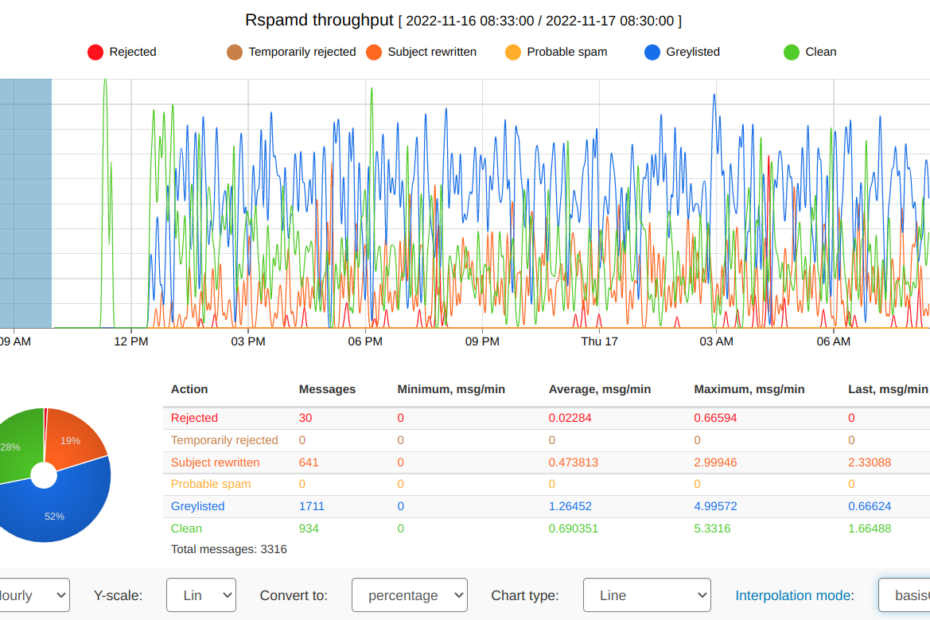

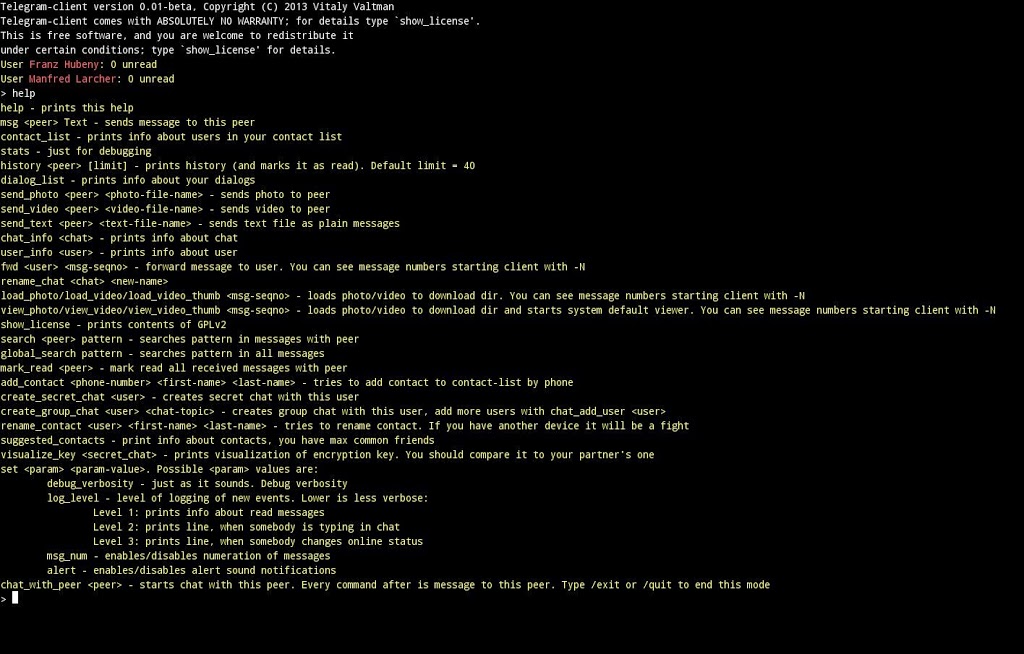

Mail Anhänge mit Rspamd per Whitelist filtern

Mein bisheriger Ansatz war es via Blacklist die Anhänge zu filtern und nur jene zum Empfänger durch zu lassen die auf die Blacklist nicht anschlugen. Bei der Vielzahl von Dateiendungen und der Kreativität von Entwicklern… Weiterlesen »Mail Anhänge mit Rspamd per Whitelist filtern