Veeam Agent for Linux ignoriert .vdi Files

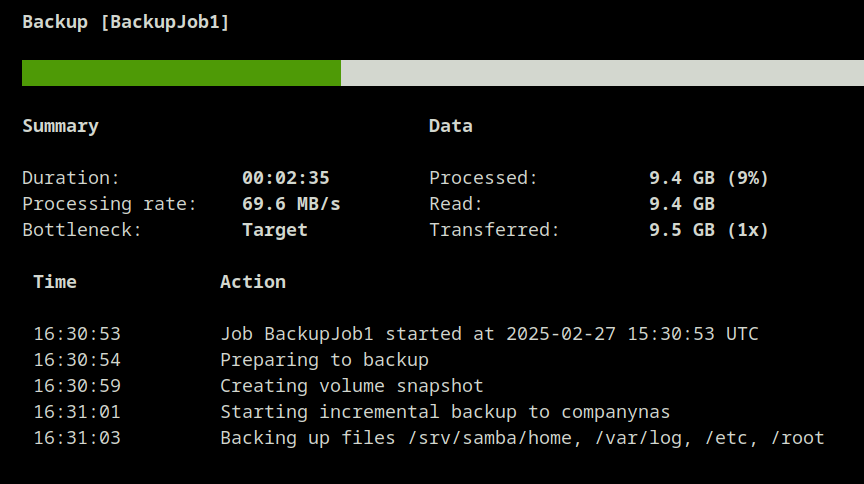

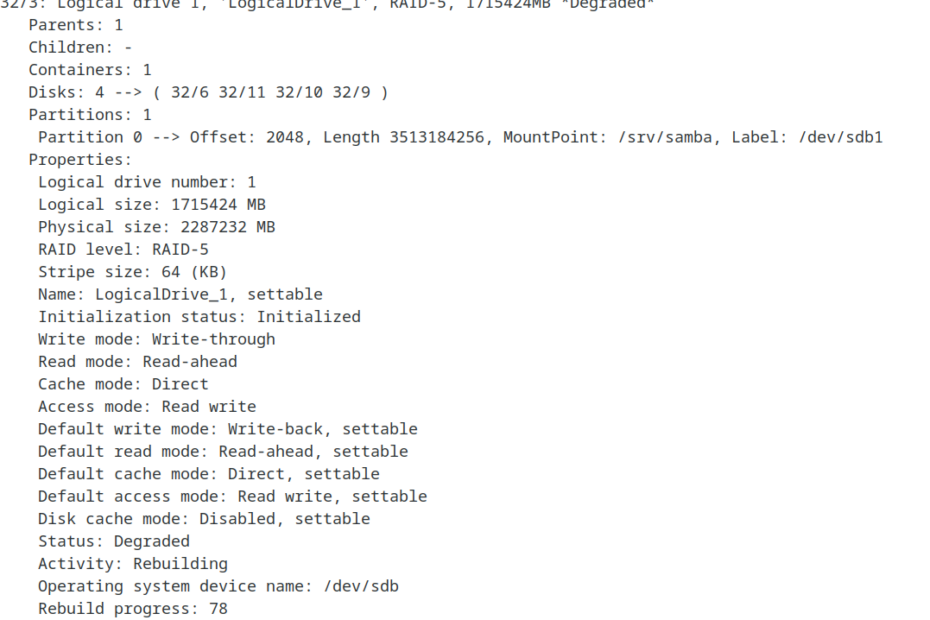

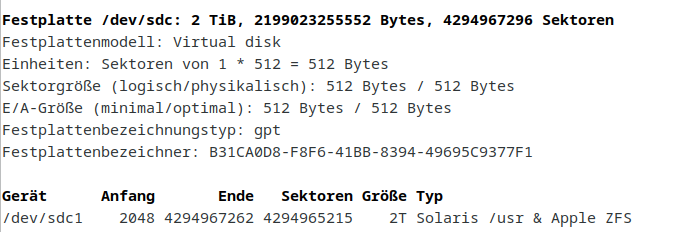

Auf einem Linux System mit installiertem Veeam Agent wird auf File-Level Basis eine Sicherung des Home-Verzeichnisses erstellt, das funktionierte bisher einwandfrei. Nach dem Erstellen einer Virtuellen Maschine mit ca. 100 GB läuft das manuell angestoßene… Weiterlesen »Veeam Agent for Linux ignoriert .vdi Files