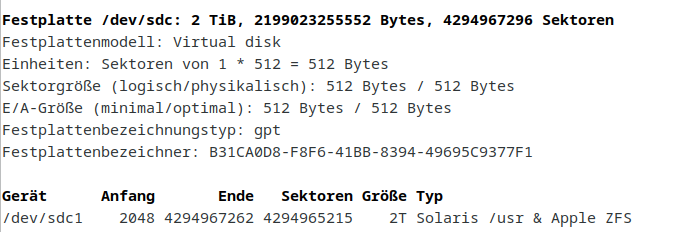

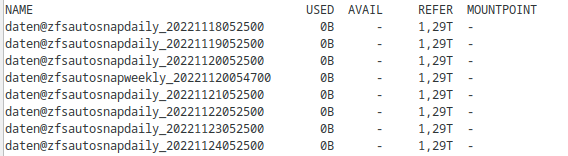

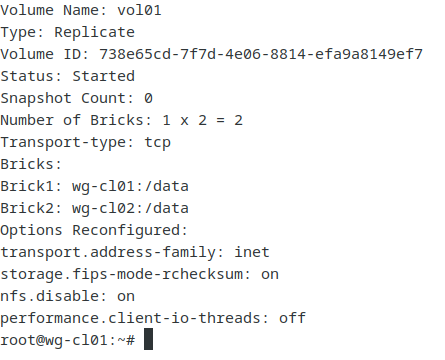

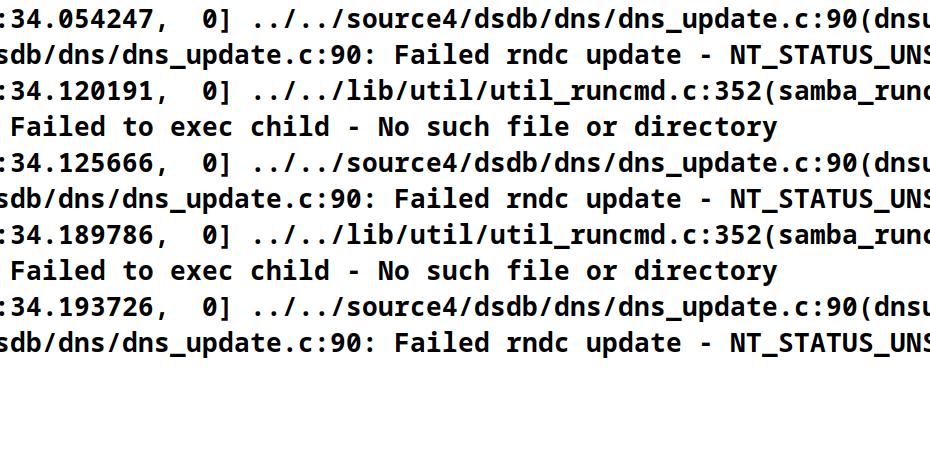

VM – ZFS Partition online vergrößern

Man macht es nicht jeden Tag, darum schadet es nicht sich’s kurz zu notieren… Hier kommen die Befehle die nötig sind um eine Platte einer VM zu online vergrößern, vorausgesetzt sie wurde im VMWare, Proxmox… Weiterlesen »VM – ZFS Partition online vergrößern